La science de l’évaluation des politiques publiques

Publié en ligne le 11 mars 2024 - Science et décision -

Certaines méthodes statistiques permettent de savoir le véritable effet d’une politique publique, sans confondre causalité (les conséquences des décisions prises) et corrélation (ce qui a pu se produire pour éventuellement d’autres raisons). Elles sont pourtant méconnues du grand public et d’une partie des décideurs et la France souffre d’un retard en termes de production de telles études d’impact [1].

Pour savoir si une politique a fonctionné, il ne suffit pas de constater que la situation est meilleure ou pire après cette politique. Si le chômage a baissé après une réforme du marché du travail, peut-être aurait-il diminué de toute façon, même sans elle. Si les émissions de CO2 ont augmenté après la mise en place d’une taxe carbone, peut-être que l’augmentation des émissions aurait été plus forte encore sans la taxe. Comment savoir dans ce qui s’est passé ce qui relève de la politique mise en œuvre et ce qui relève d’autres facteurs ?

Grâce aux progrès de l’inférence causale (une approche mathématique du concept de causalité) et aux méthodes statistiques associées [2], il est possible de répondre à cette question. Ces méthodes sont maintenant largement utilisées dans la recherche en science économique, où leur diffusion est une facette de ce qu’on qualifie de « tournant empirique » dans la discipline [3]. Elles sont aussi employées en science politique aux États-Unis [4, 5] et se diffusent en santé publique et en épidémiologie [6]. Par-delà les revues scientifiques, des laboratoires d’évaluation des politiques publiques comme l’Institut des politiques publiques 1 emploient régulièrement ces approches.

L’essai contrôlé randomisé : coûteux mais (souvent) convaincant

Imaginez que vous soyez le nouveau ministre de l’Éducation nationale. Pour améliorer le niveau moyen des élèves et réduire les inégalités, vous cherchez à savoir quelles politiques éducatives ont fonctionné dans le passé et pourraient fonctionner dans le contexte présent. Ce n’est pas chose aisée. Si le niveau a baissé après la mise en place d’une politique, est-ce à cause de cette politique ou bien un autre facteur est-il à incriminer (comme par exemple la fermeture des écoles durant la Covid-19) ? Si les politiques déployées en réseau d’éducation prioritaire n’ont pas permis de combler l’écart de réussite scolaire entre ces territoires et le reste du pays, peut-on néanmoins dire que ce fossé aurait été plus grand en l’absence de ces politiques ciblées ?

Un premier moyen pour contourner ce problème est de mener un essai contrôlé randomisé, à l’image de ce qui se fait en médecine. À la demande de chercheurs, on tire au sort les élèves qui bénéficieront d’une politique et ceux qui en seront exemptés dans un premier temps. Imaginons alors que ceux qui ont bénéficié de la politique affichent en moyenne de meilleurs résultats scolaires. Ce sera la preuve d’un effet de la politique : en effet, si on tire au sort, et qu’on mène plusieurs essais randomisés de grande taille, il n’y a pas de raison systématique qui puisse expliquer que des élèves qui auraient plus de chances de réussir pour d’autres raisons que la politique se retrouvent dans le « groupe traitement » plutôt que dans le « groupe contrôle ». Le seul facteur qui distingue les deux groupes est le « traitement » mis en œuvre (la politique appliquée).

L’essai contrôlé randomisé permet en outre d’obtenir une estimation plus rigoureuse des impacts financiers d’une politique sociale. Les coûts pour l’État d’une politique sont souvent la seule dimension financière qui vient à l’esprit alors qu’il peut aussi exister des conséquences en termes de recettes. C’est par exemple le cas quand elle améliore la réussite scolaire et, en conséquence, l’employabilité et les salaires. De même, toute politique qui réduit la délinquance réduit les coûts d’incarcération. En comparant ce bénéfice estimé aux coûts, on réalise alors que certaines politiques rapportent plus que ce qu’elles ne coûtent à l’État.

Le cas emblématique du Perry Preschool Project mené dans les années 1960 aux États-Unis et évalué par un essai contrôlé randomisé [7] illustre ce point. Il s’agissait d’une politique ciblée sur des enfants avec des QI inférieurs à 85 à trois ans. Le programme consistait en du soutien préscolaire de 2 h 30 chaque matin pendant deux ans et de visites d’un psychologue au domicile familial pour promouvoir les interactions parents‐enfants. Au bout de quarante ans, chaque dollar dépensé dans le cadre de cette politique en a rapporté dix en recettes fiscales pour l’État grâce à l’effet du programme sur l’emploi, le salaire et la délinquance [8]. Plus généralement, les estimations les plus fiables de l’effet de 133 politiques sociales menées aux États-Unis au XXe siècle montrent que la plupart des politiques ciblées sur les enfants ont rapporté plus qu’elles n’ont coûté [9].

Les critiques formulées

Des critiques plus ou moins pertinentes sont souvent formulées à l’égard de l’usage d’essais contrôlés randomisés pour évaluer des politiques publiques.

Une des plus fréquentes est qu’on ne peut pas savoir si une politique testée à une époque et dans un pays donné va avoir le même effet dans un nouveau contexte. Il est en réalité toujours possible de répliquer et comparer les résultats dans différents contextes et des résultats similaires peuvent apparaître. Ce fut le cas par exemple des programmes du type « internat d’excellence » en France 2 [10] ou charter schools aux États-Unis [11], qui ont, dans les deux pays, augmenté dans des proportions comparables les résultats des étudiants en mathématiques, mais pas en langues [12]. Si toutefois les résultats divergent, c’est l’occasion d’enrichir la théorie pour expliquer les différences.

Certains ont également insisté sur le biais qui naît quand le groupe traitement affecte le groupe contrôle [13]. Par exemple, si un programme de retour à l’emploi est évalué par un essai contrôlé randomisé et qu’il s’avère efficace, les membres du « groupe traitement » peuvent, par leur consommation, créer des emplois qui pourront bénéficier aux membres du « groupe contrôle », ce qui conduit à sous-estimer les bénéfices de la politique. Ce problème n’est toutefois pas spécifique aux sciences sociales : en médecine, par exemple, l’immunité collective peut créer un biais comparable. Et il n’est pas rédhibitoire : une méthodologie adaptée permet d’en tenir compte dans les études (voir par exemple [14, 15]).

D’autres insistent sur le fait que ces approches causales doivent être complémentés par des études non causales des politiques publiques [16]. Plus courantes en sociologie, en France en particulier, ces études reposent sur des entretiens et des sondages des bénéficiaires d’une politique. Si leur but n’est pas d’apporter de preuve de causalité (elles ne construisent pas de groupe contrôle), elles sont très utiles pour aider à comprendre les raisons de la popularité ou de l’impopularité d’une mesure. Les termes employés par un bénéficiaire d’une politique peuvent aussi aider le chercheur à comprendre certains mécanismes qui font qu’une intervention a fonctionné ou échoué, et quels effets secondaires potentiels devraient être par la suite mesurés (dans une étude quantitative).

Enfin, reste un obstacle majeur d’ordre politique et éthique à l’organisation d’un essai contrôlé randomisé. Les décideurs peuvent s’opposer à l’idée d’affecter aléatoirement des ressources ou des avantages à seulement une fraction de la population concernée, fût-ce le temps d’une évaluation. Deux solutions s’offrent alors au chercheur : trouver des tirages au sort « naturels » ou recourir à d’autres méthodes dites quasi expérimentales.

Le tirage au sort « naturel »

Une première solution consiste à trouver des cas où il y a bien eu tirage au sort, mais sans que ce soit pour les besoins de l’étude. On appelle ces cas des « expériences naturelles ». Une étude menée en 2013 [17] l’illustre sur un exemple. Elle s’est penchée sur les effets de Medicaid, la politique de Barack Obama visant à aider les ménages à faible revenu à couvrir leurs frais médicaux. En 2008, dans l’Oregon, des tirages au sort ont été effectués à partir d’une liste d’attente. Ceux qui ont été sélectionnés ont immédiatement bénéficié de Medicaid (ils constituent alors le « groupe de traitement »).

Les non-sélectionnés n’ont eu accès à Medicaid que plus tard (et forment symétriquement le « groupe contrôle »). Le programme a conduit à une meilleure détection du diabète, à une réduction des taux de dépression et à un allégement des contraintes financières.

De nombreux articles de recherche en économie sont célèbres pour avoir exploité un tel tirage au sort « naturel ». En macroéconomie, lorsqu’un État distribue de l’argent pour contrer une récession, il est important de savoir si les ménages vont consommer ce revenu supplémentaire, ce qui est une condition nécessaire pour atténuer la crise, ou s’ils vont préférer l’épargner, par prudence ou parce que leur mode de vie dépend essentiellement de leur revenu stable et « permanent » [18] (comme leur salaire). Or lors d’une récession, il est impossible de justifier politiquement de ne verser une aide qu’à la moitié des citoyens pour connaître son impact précis sur la consommation. Dans une contribution célèbre en macroéconomie [19], des chercheurs ont trouvé un moyen de contourner ce problème. Ils exploitent le fait qu’aux États-Unis, pour des raisons logistiques, un chèque de soutien aux ménages après la récession de 2008 n’a pas pu être simultanément distribué à tous les Américains. L’administration fiscale américaine a déterminé la date exacte à laquelle chaque ménage recevrait le chèque grâce à l’avant-dernier chiffre du numéro de sécurité sociale, qui est attribué de manière aléatoire. De fait, se sont formés au hasard un « groupe traitement » (qui a reçu le chèque en premier) et un « groupe contrôle » (qui a reçu le chèque plus tard). L’étude montre que les ménages ont consommé assez massivement ce revenu supplémentaire, amoindrissant la récession.

Les quasi-expériences

Il est malgré tout rare qu’une politique soit déployée sur la base d’un tirage au sort. Une solution consiste alors à recourir aux quasi-expériences. Ce terme désigne diverses méthodes qui permettent de tenter de démêler corrélation et causalité lorsque la réalisation d’expériences classiques est impossible. Une abondante littérature scientifique qui mêle preuves mathématiques, simulations informatiques et comparaisons entre méthodes montre en effet que certaines méthodes ont cette caractéristique (voir par exemple [20], chapitre 9). Si leur mise en œuvre peut parfois être très technique, elles reposent souvent sur des principes intuitifs. L’une des plus courantes en économie est le « différence-en-différence » (voir encadré ci-après).

Bien qu’elle soit aujourd’hui largement employée en sciences sociales quantitatives, la méthode du « différence-en-différence » trouve ses origines en santé publique. Elle a été utilisée à l’origine, en 1854 à Londres, par l’épidémiologiste John Snow pour démontrer comment le choléra se propage par l’eau contaminée [1]. Plus tard, des économistes l’ont modernisée pour étudier l’impact du salaire minimum sur l’emploi [2], contribuant à sa diffusion dans la discipline et au-delà. Son principe de base est simple. Imaginons qu’une nouvelle pandémie, la Covid-23, éclate et que le gouvernement français envisage un nouveau confinement.

Pour évaluer les effets du nouveau confinement, on peut employer la méthode du « différence-en-différence » : on identifie un autre pays présentant des évolutions d’infections comparables à celle de la France avant le confinement, mais qui n’a pas mis en place de mesures similaires. Une hypothèse centrale de cette méthode est que, en l’absence de confinement, les deux pays auraient continué à suivre une trajectoire d’infections comparable. Si aucune autre mesure politique n’a été mise en œuvre en même temps que le confinement, cette hypothèse semble raisonnable. Si un autre événement susceptible d’affecter les infections se produit en même temps que le confinement (par exemple, une vague de protestations incitant à continuer à sortir), cette approche ne permettra d’estimer que l’effet cumulé des deux mesures (quoique dans l’exemple précédent on puisse arguer que le deuxième événement est un des effets du premier).

Cette méthode repose sur l’existence d’un pays dans lequel les infections ont évolué de manière similaire à celles de la France avant la mise en place du confinement. Mais que faire si un tel pays n’existe pas ? Une solution possible est alors de recourir à la méthode dite du « contrôle synthétique ».

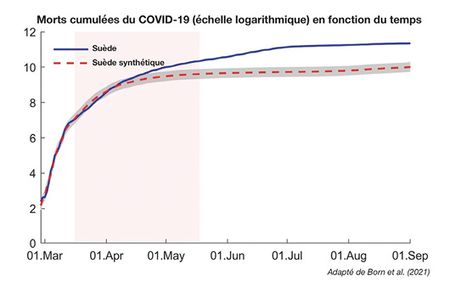

Une illustration de cette méthode se trouve dans une étude de 2021 [4] qui évalue l’effet de l’absence de confinement en Suède pendant la crise de la Covid-19 par rapport à un groupe de contrôle de pays qui l’ont mis en place. Dans le graphique, la ligne bleue représente le nombre de morts en Suède et celle en pointillés celle d’une Suède « synthétique ». Cette Suède synthétique est en fait une moyenne pondérée d’autres pays ayant mis en place des confinements (Norvège, Danemark, Finlande, Pays-Bas…). Une moyenne pondérée est une moyenne dans laquelle certains pays ont plus de poids que d’autres. Ici, ces poids sont ajustés par un algorithme pour que le nombre d’infections corresponde aux chiffres de la Suède jusqu’à ce que les « pays contrôle » mettent en place un confinement. Ainsi, le fait que le nombre de morts soit plus important dans la Suède réelle que dans la Suède synthétique à partir de la vague de confinements suggère que la Suède aurait évité des morts en confinant.

Nota : l’échelle des ordonnées est une échelle logarithmique qui tend à aplatir la courbe. L’aire en rose correspond à la période où les pays du groupe contrôle ont commencé à confiner.

Cette approche par contrôle synthétique n’est qu’une méthode pour trouver un groupe contrôle pertinent. D’autres sont possibles, comme par exemple celle, plus populaire, qui consiste, pour constituer un groupe de contrôle, à employer des algorithmes de matching qui fouillent les bases de données pour associer les individus qui ont été affectés par une politique à d’autres, « non-traités » mais qui leur sont similaires sur des caractéristiques données (revenu, éducation...) et avaient des trajectoires comparables avant la politique. Ces méthodes ainsi que bien d’autres sont présentées dans des manuels d’inférence causale [3].

Références

1 | Caniglia EC, Murray EJ, “Difference-in-difference in the time of cholera : a gentle introduction for epidemiologists”, Current Epidemiology Reports, 2020, 7 :203-11.

2 | Card D, Krueger AB, “Minimum wages and employment : a case study of the fast food industry in New Jersey and Pennsylvania”, National Bureau of Economic Research Working Paper Series, octobre 1993. Sur nber.org

3 | Scott C, Causal inference, Yale University Press, 2021.

4 | Born B et al., “The lockdown effect : a counterfactual for Sweden”, Plos One, 2021,16 :e0249732.

L’importance des arbitrages politiques

L’évaluation des politiques est parfois défendue avec l’argument qu’elle permettrait de dépasser les clivages politiques en déterminant quelle politique serait bonne ou mauvaise dans l’absolu. Cette position faussement apolitique s’incarne par exemple dans les propos de l’ancien premier ministre du Royaume-Uni Tony Blair : « Il n’y a pas de politiques économiques de gauche ou de droite, mais des politiques qui sont efficaces ou ne le sont pas » [21]. La formule est percutante. Mais elle est construite autour d’un faux dilemme. Certaines politiques réussissent dans le sens où elles atteignent leurs objectifs. D’autres échouent. Pourtant, cela n’implique pas qu’une politique puisse être choisie seulement à l’aide de critères scientifiques.

Selon son orientation politique, le citoyen peut valoriser des objectifs différents. Le débat sur le taux d’imposition de 90 % sur la dernière tranche de revenu aux États-Unis entre 1951 et 1963 l’illustre. Certains libéraux ont argué qu’un tel taux serait trop haut pour remplir les caisses de l’État, car il découragerait à travailler ou inciterait à pratiquer l’évasion fiscale. Néanmoins, des auteurs rappellent qu’on peut soutenir cette politique simplement parce qu’elle compresse la hiérarchie des revenus, indépendamment de son impact sur les recettes fiscales [22]. Ainsi, savoir si une taxe à plus de 90 % sur la dernière tranche de revenu « fonctionne » ou non dépend en premier lieu de l’objectif qu’on lui attribue et des effets associés qu’on est prêt à assumer : contenir les rémunérations en dessous d’un niveau jugé indécent ou augmenter les ressources fiscales de l’État.

Si l’évaluation des politiques publiques permet de savoir dans quelle mesure la politique atteint respectivement ces objectifs, elle ne permet pas de savoir quel but est le bon, ou est le plus important.

L’association britannique Sense about Science développe depuis quelques années une campagne portant sur la transparence des preuves dans la décision publique [1]. Une enquête d’opinion menée chaque année depuis 2019 [2] révèle que le public estime que le gouvernement n’accorde pas assez d’importance aux preuves et données disponibles ainsi qu’aux avis des experts. En règle générale, regrette l’association, le gouvernement ne publie pas les résultats des études qu’il a commanditées et les données sous-jacentes aux décisions prises restent souvent inaccessibles. En conséquence, environ 60 % des personnes estiment que les députés ne sont pas en mesure de questionner correctement le gouvernement sur la base des preuves, dans toute une série de domaines, en particulier ceux portant sur la santé publique, le climat et l’énergie ou encore l’intelligence artificielle.

Sense about Science a ainsi regretté que « le gouvernement britannique [ait] considéré la communication sur la façon dont il utilise les preuves dans la pandémie comme superflue » [3], reportant à des temps plus calmes la justification des mesures prises.

Pour l’association, la confiance du public dans les décisions gouvernementales dépend de cette transparence. Elle propose un système de normes qu’elle a élaboré conjointement avec l’Institute for Government qui expliciterait la manière de procéder [4]. Ce cadre normatif se décompose en quatre parties :

- le « diagnostic de la situation » rendrait compte de ce que les décideurs politiques savent du problème qu’ils entendent aborder, de ses causes, de ses effets et de son ampleur ;

- la « proposition » décrirait les raisons de la décision, les alternatives écartées, les preuves disponibles, les données existantes et les expériences précédentes, les coûts et bénéfices attendus, ainsi que les hypothèses sous-jacentes à cette évaluation ;

- la « mise en œuvre » décrirait les modalités d’application retenues, les preuves et données sous-jacentes si elles existent ainsi que, là aussi, une analyse coût-bénéfices explicitant les hypothèses retenues ;

- la partie « tests et évaluation » décrirait la méthodologie retenue permettant d’évaluer a posteriori dans quelle mesure la politique a fonctionné.

Références

1 | “Transparency of evidence”, site de Sense about Science, 2023. Sur senseaboutscience.org

2 | “Attitudes towards evidence among the GB public”, Ipsos/Sense about Science Evidence Week, juin 2023. Sur senseaboutscience.org

3 | Transparency matters”, site de Sense about Science, 2023. Sur senseaboutscience.org

4 | “Transparency of evidence : an assessment of government policy proposals May 2015 to May 2016“, Sense about Science, novembre 2016. Sur senseaboutscience.org

Conclusion

Construire un corpus de connaissances scientifiques fiables sur l’effet d’une politique est long et coûteux. Ceci nécessite de mêler analyses descriptives, entretiens qualitatifs, et expériences et quasi-expériences dûment répliquées. Cette approche est néanmoins bien plus fiable que celle, naïve ou malhonnête, qui consiste à attribuer ce qui se passe après une politique à cette politique, ou même à ne consulter aucune donnée.

Un rapport de France stratégie [23] suggère qu’une telle conception pseudo-scientifique de l’évaluation des politiques publiques a tout pour perdurer en France. Il souligne la quasi-absence de culture scientifique de l’évaluation parmi les hauts fonctionnaires français, alors qu’en Grande-Bretagne, des standards de compétences techniques en évaluation ont été définis et sont utilisés pour leur recrutement et leur évolution professionnelle [24]). Le rapport montre le fossé qui existe entre la recherche académique et les administrations, alors qu’aux États-Unis, des dispositifs comme l’Intergovernemental Personnel Act (IPA) permettent aux chercheurs d’apporter leur expertise sur un projet donné [25]. Enfin, ce travail montre le retard de la France dans la production d’études d’impact par rapport aux autres pays de l’OCDE. Faute d’une forte demande citoyenne qui puisse se coupler à celle des scientifiques, la pseudo-science de l’évaluation des politiques publiques a tout un milieu pour se perpétuer.

1 | Bono PH et al., « Le lent développement des évaluations d’impact en France : une approche par les acteurs », Revue française d’administration publique, 2021, 177 :17-28.

2 | Imbens GW, Rubin DB, Causal inference in statistics, social, and biomedical sciences : an introduction, Cambridge University Press, 2015.

3 | Angrist JD, Pischke JS, “The credibility revolution in empirical economics : how better research design is taking the con out of econometrics”, Journal of Economic Perspectives, 2010, 24 :3-30.

4 | Dunning T, “Improving causal inference”, Political Research Quarterly, 2008, 61 :282-93.

5 | Clark WR, Golder M, “Big Data, causal inference, and formal theory : contradictory trends in political science ?”, Political Science and Politics, 2014, 48 :65-70.

6 | Wing C et al., “Designing difference in difference studies : best practices for public health policy research”, Annual Review of Public Health, 2018, 39 :453-69.

7 | Belfield CR et al., “The high/scope perry preschool program”, Journal of Human Resources, 2006, 41 :162-90.

8 | Heckman JJ et al., “The rate of return to the Highscope Perry Preschool Program”, Journal of Public Economics, 2010, 94 :114-28.

9 | Hendren N, Sprung-Keyser B, “A unified welfare analysis of government policies”, The Quarterly Journal of Economics, 2020, 135 :1209-318.

10 | Ministère de l’Éducation nationale et de la Jeunesse, « Vivre sa scolarité dans un internat d’excellence », avril 2023. Sur education.gouv.fr

11 | Office of Elementary and Secondary Education, “Charter school programs”, 9 juillet 2023. Sur oese.ed.gov

12 | Behaghel L et al., “Ready for boarding ? The effects of a boarding school for disadvantaged students”, American Economic Journal : Applied Economics, 2017, 9 :140-64.

13 | Deaton A, Cartwright N, “Understanding and misunderstanding randomized controlled trials”, Social Science and Medicine, 2018, 210 :2-21.

14 | Miguel E, Kremer M, “Worms : identifying impacts on education and health in the presence of treatment externalities”, Econometrica, 2004, 72 :159-217.

15 | Crépon B et al., “Do labor market policies have displacement effects ? Evidence from a clustered randomized experiment”, The Quarterly Journal of Economics, 2013, 128 :531-80.

16 | Baïz A, Revillard A, « Comment articuler les méthodes qualitatives et quantitatives pour évaluer l’impact des politiques publiques ? Un guide à l’usage des décideurs et des praticiens », France Stratégie, décembre 2022. Sur strategie.gouv.fr

17 | Baicker K et al., “The Oregon experiment : effects of medicaid on clinical outcomes”,New England Journal of Medicine, 2013, 368 :1713-22.

18 | Friedman M, A theory of the consumption function, National Bureau of Economic Research, 1957.

19 | Broda C, Parker JA, “The economic stimulus payments of 2008 and the aggregate demand for consumption”, Journal of Monetary Economics, 2014, 68 :20-36.

20 | Scott C, Causal inference, Yale University Press, 2021.

21 | Lefèbvre R, « Le brouillage du clivage gauche/droite », in Leçons d’introduction à la science politique, 2017, p. 235.

22 | Saez E et al., Le Triomphe de l’injustice : richesse, évasion fiscale et démocratie, Points-Seuil, 2021.

23 | Baïz A et al., « Vingt ans d’évaluations d’impact en France et à l’étranger : analyse comparée dans six pays », Document de travail n° 2019-16, France Stratégie, décembre 2019. Sur strategie.gouv.fr

24 | “Guidance policy profession standards”, site du gouvernement du Royaume-Uni, 25 avril 2022. Sur gov.uk

25 | U.S. Office of Personnel Management, “Intergovernment Personnel Act”, 2023. Sur opm.gov

1 Partenariat scientifique entre l’École d’économie de Paris et le Centre de recherche en économie et statistique (Crest).

2 Collège ou lycée pour des élèves de quartiers défavorisés dans lequel vivent les élèves et les adultes qui les encadrent, tout au long de la semaine. En plus des cours, les internes bénéficient d’un accompagnement pédagogique personnalisé.

Thème : Science et décision

Mots-clés : Économie

Publié dans le n° 346 de la revue

Partager cet article

L' auteur

Louis Fréget

Doctorant en microéconométrie appliquée à l’université de Copenhague. Il travaille sur des questions liées aux (…)

Plus d'informationsScience et décision

![[Metz- 14 novembre 2019] Science et santé. Que croire ? Qui croire ?](local/cache-gd2/21/cb1c4ec067d43cf7c7dd0d04739b1f.jpg?1681567311)

[Metz- 14 novembre 2019] Science et santé. Que croire ? Qui croire ?

Le 14 novembre 2019

Les « données probantes » et la décision

Le 12 juillet 2024

Une expérience de pensée : le dilemme du tramway fou

Le 13 juin 2024

Claude Got (1936-2023)

Le 14 mars 2024

La science de l’évaluation des politiques publiques

Le 11 mars 2024

Hiérarchisation des peurs et priorisation des enjeux

Le 17 janvier 2024Communiqués de l'AFIS