Comment assure-t-on la sécurité des constructions ?

Publié en ligne le 19 septembre 2011 - Conspirationnisme -Depuis que l’homme construit, il doit faire face à des défaillances d’ouvrages. Plus que d’autres secteurs de l’ingénierie, celui des constructions est proche des usagers. Chacun de nous passe l’essentiel de son temps entre des murs, avec un toit sur la tête, emprunte des ponts, des tunnels... Les risques éventuels que nous font courir des structures défaillantes sont donc plus subis que choisis. Les spécialistes de ces questions savent que nous sommes prêts à prendre des risques plus élevés pour des activités librement choisies que pour des activités qui nous sont imposées. Dans le premier cas, la recherche d’un gain (sensations, plaisir...) est volontaire (sports extrêmes, tabac...). Dans le second cas (activités de la vie quotidienne, travail...) nous demandons à la société de nous garantir la sécurité. C’est la raison pour laquelle, très tôt dans l’histoire de l’humanité, les constructeurs ont dû mettre en place des règles pour garantir un degré de sécurité suffisant pour les constructions.

Un souci vieux de plusieurs milliers d’années

Le barrage de Saad El Kafara fut construit sur le Nil il y a 4 600 ans. C’était un barrage mixte de terre et de maçonnerie, de 12 mètres de haut, sans déversoir, car les constructeurs n’avaient probablement pas anticipé le risque de crue. Il fut détruit à la première crue. La population fut si choquée par ce désastre qu’il fallut attendre plus de 1 000 ans pour que de nouveaux barrages soient construits sur le Nil.

La nécessité d’émettre des règles apparaît dès lors que le concepteur ou le constructeur ne sont plus les utilisateurs de l’ouvrage et qu’ils font courir un danger potentiel à d’autres personnes. Le plus ancien code qui nous soit parvenu est celui d’Hammourabi, établi à Babylone, vers 1700 av. J.C. Dans ce texte, les maçons ou les constructeurs de digues dont les ouvrages s’effondreraient sont reconnus responsables et punis de diverses peines, pouvant aller jusqu’à la mort, graduées selon les conséquences des défaillances. Dans la Rome Antique, l’effondrement de l’amphithéâtre de Fidenes, en l’an 27, a causé plusieurs dizaines de victimes. Cette catastrophe marqua profondément les Romains, conduisant à une législation très sévère sur l’organisation de spectacles sportifs dans l’Empire. Ainsi, fut-il décidé que personne ne pourrait donner un spectacle s’il avait une fortune inférieure à 40 000 sesterces (soit approximativement 40 000 euros pour 2011) et qu’il serait interdit de construire un amphithéâtre ailleurs que sur un sol d’une solidité éprouvée. Les Romains introduisirent aussi en 385 ap. J.C (Constitution de Gratien et de Théodose) la responsabilité de quinze années de l’architecte en matière de travaux publics [Blondeau et al, 2008].

Plus près de nous, le célèbre pont de Mostar, sur la Neretva, faisait l’admiration des voyageurs par la hardiesse de ses formes au-dessus du ravin depuis sa construction entre 1557 et 1566. La légende dit que le sultan Soliman avait menacé l’architecte Hajreddin de le raccourcir d’une tête si le pont s’effondrait. Le pont avait franchi les siècles jusqu’aux bombardements de la guerre de Bosnie en 1993.

L’histoire des constructions, jusqu’au XVIIIe siècle en Occident, fait la part belle aux expérimentations en vraie grandeur, avec le développement de copies, de variantes, et des progrès réguliers, souvent accompagnés d’échecs. Le concept de coefficient de sécurité est introduit pour la première fois pour la largeur d’un mur de soutènement soumis au poids des terres : augmenter sa largeur de 25 % assurait sa stabilité au renversement avec une sécurité suffisante. Jusqu’au XIXe siècle, dans les ouvrages en pierre ou en maçonnerie, le poids propre, permanent, excédait largement les effets des actions variables (surcharges d’exploitation, actions climatiques) : dès lors, si l’ouvrage était stable au moment de la construction, il était hautement probable que, correctement entretenu, il le demeurerait au fil des ans. Les marges de sécurité n’étaient pas calculées, et présentaient, de fait, peu d’intérêt.

Vers une réglementation scientifique

Avec, à la fin du XVIIIe siècle et au début du XIXe siècle, le développement de la construction en fonte et en fer, les ouvrages s’allègent et la part des actions extérieures augmente. La sécurité, jusque-là essentiellement liée à la stabilité, devient aussi une question de résistance des matériaux. En outre, la variabilité temporelle devient significative et un ouvrage satisfaisant à sa construction peut s’avérer déficient par la suite, ou sous l’effet de sollicitations exceptionnelles. La multiplication des défaillances d’ouvrages conduit aux premières expérimentations, que le développement de la science (résistance des matériaux) permet peu à peu de concevoir et d’interpréter. On introduit alors le concept de coefficient de sécurité F, défini comme le rapport de la charge de rupture à la charge effectivement appliquée.

L’essor de la réglementation et de la codification est rapide. Au début du XXe siècle, la réglementation des calculs en béton armé est rendue nécessaire par la complexité du comportement de ce matériau nouveau. Les premiers codes français de béton armé reposent sur la notion de contrainte admissible : le dimensionnement est satisfaisant dans la mesure où les contraintes régnant dans l’ouvrage ne dépassent pas une fraction 1/F des contraintes de rupture. La grandeur F est qualifiée de « coefficient de sécurité ». Elle matérialise la marge de sécurité et tient compte de toutes les sources d’incertitude. La fixation des valeurs des coefficients de sécurité repose sur l’empirisme et le retour d’expérience. Les valeurs retenues pour les coefficients de sécurité ont décru avec le progrès des connaissances. Par exemple, en maçonnerie, une valeur de 10 était ordinaire en 1880, quand on ne demandait plus que 7 ou 8 dix ans plus tard. Au XXe siècle, cette valeur est descendue à 5 puis à 4, et une valeur de 3 est aujourd’hui choisie pour le recalcul des structures historiques. On ne peut conserver une sécurité effective identique tout en abaissant les valeurs du coefficient de sécurité qu’en réduisant les incertitudes.

Depuis 25 ans environ, la modélisation de la sécurité dans la construction a franchi une nouvelle étape, qui consiste à distinguer dans les calculs de dimensionnement trois « coefficients partiels » de sécurité : un premier porte sur les matériaux de construction, un autre sur les actions que subiront les ouvrages, le dernier sur les imprécisions de modélisation.

Pourquoi des constructions s’effondrent-elles ?

Les défaillances, parfois spectaculaires, de constructions de tous types, sont hélas relativement fréquentes. Un recensement partiel (hors catastrophes naturelles) des effondrements d’ouvrages dans le monde en 2010 a permis d’en documenter plus de 110, dont plus de 20 ponts. Les origines sont multiples : crues, chocs, surcharges, erreurs de conception... Tous les pays sont concernés par ces défaillances.

Les causes des défaillances peuvent être classées de différentes manières. Concrètement, si un ouvrage s’effondre, c’est toujours parce que, à un moment donné, l’effet des actions qu’il subit dépasse les capacités de résistance ou de stabilité : poids de la neige excessif sur une toiture, choc violent sur une pile de pont, matériau affaibli par un incendie... Mais, si nous dépassons ce regard technique, on peut globalement classer les défaillances en deux familles : les défaillances que l’on qualifiera de « normales » et celles que l’on qualifiera d’anormales.

Une défaillance « normale » est une défaillance qui se produit dans deux situations :

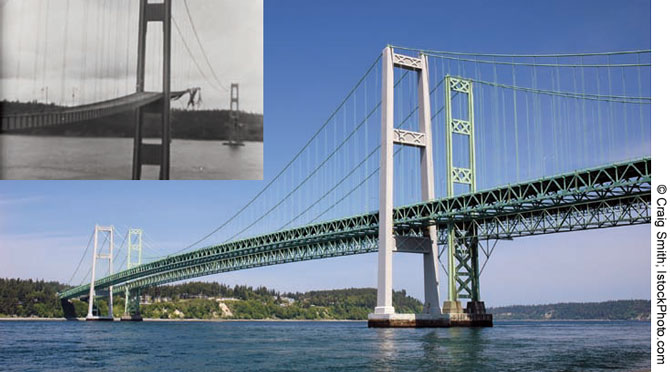

- Les actions s’exerçant sur l’ouvrage étaient « inimaginables », c’est-à-dire d’une nature ou d’une intensité que l’on ne pouvait pas raisonnablement prévoir. Ainsi, une charge de neige sur une toiture peut être réellement exceptionnelle (au sens où elle dépasse largement les niveaux atteints dans le passé dans la même zone géographique). Un autre exemple est celui du fameux Pont de Tacoma, qui s’est rompu le 7 novembre 1940 sous l’effet de vibrations de grande amplitude, résultant d’un couplage aéro-élastique : les effets du vent ont provoqué la torsion du tablier, qui a elle-même amplifié localement les effets du vent, qui... Le phénomène physique en jeu était inconnu au moment de la conception, et n’a été bien compris que près de vingt ans plus tard.

- On a volontairement choisi de ne pas concevoir l’ouvrage pour résister à des actions de cette ampleur. Il s’agit là d’un choix délibéré, sur la base d’un arbitrage économique. Dans tous les domaines de la sécurité, on doit fixer à l’avance le niveau de fiabilité que l’on vise (par exemple en termes de probabilité de défaillance), et mettre ensuite en place une démarche (par la réglementation, la gestion de la qualité, le contrôle, l’entretien), qui garantisse effectivement la fiabilité visée. Dans le domaine des constructions, les réglementations sont conçues (et les coefficients partiels cités ci-dessus choisis) de manière à assurer des niveaux de fiabilité de l’ordre de 10-3 à 10-6. Cela signifie que la défaillance est jugée normale si elle se produit une fois sur mille (10-3) ou une fois sur un million (10-6). Cette probabilité n’a de sens que dans un cadre statistique : elle peut être interprétée en disant que sur N ouvrages dans la même situation, en moyenne un ouvrage sera défaillant, si la probabilité est 1/N. Le niveau de fiabilité visé dépend principalement des conséquences possibles de la défaillance : on assurera un degré de sécurité plus élevé si ces conséquences sont potentiellement très élevées. Ainsi, la fiabilité de l’ordre de un pour mille correspondra à un hangar agricole, et celle de un pour un million à un bâtiment d’habitation. Le choix des valeurs précises n’est pas à la charge de l’ingénieur : il est fait par les experts qui, dans les instances de régulation, représentent les pouvoirs publics. Il serait bien entendu possible de choisir des niveaux de sécurité plus exigeants (et donc de modifier les coefficients de sécurité en conséquence), mais le « gain de sécurité » (diminution de la fréquence des défaillances) serait trop faible par rapport à la dépense engagée (structures plus lourdes et plus coûteuses).

Les défaillances « normales » existent donc. Elles résultent principalement des limites de nos connaissances ou des contraintes économiques qui président à nos choix en termes de sécurité. Mais, dans de nombreux cas, la défaillance peut être qualifiée d’anormale. On emploiera ce terme quand, dans un contexte habituel, des actions qui n’ont rien d’exceptionnel conduisent à l’effondrement.

Ainsi, l’effondrement du hall du Terminal 2E de Roissy, le 23 mai 2004, peut être qualifié de défaillance « anormale » : le bâtiment n’était pas réellement exceptionnel (en termes d’innovation), et il s’est effondré au petit matin, « simplement » sous l’action de son propre poids. Quand se produisent des défaillances « anormales », des dimensions humaines peuvent souvent être invoquées, qu’il s’agisse d’erreurs individuelles (oublis, « erreurs volontaires ») ou liées à l’organisation et au mode de fonctionnement des acteurs de la construction. Puisque des « coefficients partiels » ont été introduits par la réglementation, pour se prémunir séparément de problèmes sur les actions, les matériaux ou les modèles, il faut en général le concours de plusieurs circonstances défavorables pour conduire à la défaillance finale. Ainsi, dans le cas de Roissy, une conception discutable de certains détails structuraux, une robustesse insuffisante de la coque, des études numériques incomplètes, l’incapacité à observer la fissuration qui se développait et un manque de clarté dans les relations entre certains des acteurs du projet ont été autant de facteurs qui, conjugués, peuvent expliquer la défaillance finale.

L’effondrement du World Trade Center : « normal » ou anormal ?

Il n’est nul besoin d’évoquer des scénarios fantaisistes pour décrire ce qui s’est passé : les lois de la physique et celles de la résistance des matériaux sont telles que, après le choc d’une violence extrême d’un avion de ligne et l’incendie qui s’en est suivi, et l’absence de moyens de lutte anti-feu à l’échelle du problème, la seule question qui pouvait être posée était : pendant combien de temps les tours resteront-elles debout ?

Il faut néanmoins replacer cette catastrophe dans le panorama qui vient d’être évoqué. Lors de leur conception et de leur construction, les ingénieurs en charge d’édifier les tours ont fait un certain nombre de choix techniques qui expliquent la défaillance et, dans notre cas, hélas, la relativement forte vulnérabilité des tours à un tel impact.

Les tours, comme tous les immeubles de grande hauteur, étaient conçues pour résister à un défi majeur : l’action des vents de tempête. Le vent constituait l’action la plus sévère envisagée pour l’ouvrage, et a conduit à une structure dont la résistance à la flexion reposait sur la combinaison d’un cœur rigide (le « noyau central »), contenant tous les moyens de circulation verticale et d’une épaisse peau périphérique faite de multiples plaques préfabriquées. L’ensemble, solidarisé par les planchers métalliques, possédait une rigidité globale convenable pour que les déformations et les vibrations engendrées par le vent soient acceptables. D’autres solutions techniques auraient été possibles, comme celle d’un treillis tridimensionnel de poutres et de poteaux (métalliques ou en béton armé). Une telle solution aurait sans aucun doute résisté plus longtemps après le choc de l’avion mais elle n’a pas été retenue pour des raisons économiques.

L’appellation d’ingénierie forensique, qualifie un nouveau champ de l’ingénierie, qui repose sur l’analyse des défaillances techniques. Dans le domaine de la construction, il s’agit bien entendu d’analyser les causes des défaillances d’ouvrages. Ce champ (forensic engineering) est extrêmement actif dans les pays anglo-saxons. L’ingénierie forensique s’est progressivement structurée. Cette discipline dispose aujourd’hui aux États-Unis et en Grande-Bretagne de ses propres revues scientifiques et de ses conférences spécialisées.

Le vocable anglais « forensic » provient du latin forensis (public), de forum. Il qualifie initialement ce qui est du ressort de l’argumentation utilisable pour la discussion et le débat, y compris devant la justice. Il s’applique aussi, par extension, à l’application de la connaissance scientifique pour résoudre des problèmes légaux (on parle aussi de médecine forensique). Le mot « forensics » est par exemple inscrit sur les vêtements de la police scientifique qui intervient sur la scène d’un crime. En langue française, on parle de « sciences forensiques » en Suisse pour qualifier les analyses balistiques relatives aux armes à feu.

L’ingénieur forensique doit, sur la base des indices disponibles (vestiges de l’ouvrage, échantillons de matériaux, témoignages, voire enregistrement de l’effondrement, plans et études d’origine...), reconstruire le(s) scenario(s) le(s) plus probable(s) de la catastrophe. Les objectifs premiers sont souvent le besoin d’identifier des responsables, en particulier sur le plan légal. C’est d’ailleurs la judiciarisation croissante de la société anglo-saxonne qui explique en grande partie l’essor de cette discipline. La famille de Mme Del Valle, décédée à Boston le 10 juillet 2006, écrasée par la chute d’une dalle de plafond du tunnel dans lequel elle circulait en voiture, a ainsi perçu plusieurs millions de dollars pour le préjudice subi. Les expertises ont mis en évidence une raison matérielle (le fluage de la résine polymère utilisée pour fixer les chevilles métalliques soutenant les dalles), mais aussi de nombreuses raisons organisationnelles, en particulier une absence de réaction après des inspections ayant détecté des décollements partiels.

Mais l’apport de l’ingénierie forensique dépasse cette contribution immédiate. Les leçons tirées des défaillances enrichissent l’expérience collective et, sous réserve d’être correctement traitées (collectées, mises en forme, exploitées), permettent d’aller plus loin. Le Pr. Jonathan Wood l’a illustré1 au travers d’une « ronde » des quatre domaines auxquels contribue l’ingénierie forensique : le domaine judiciaire et la définition des responsabilités, la recherche et l’amélioration des savoirs, l’éducation et la formation des professionnels, l’amélioration des pratiques et de la réglementation.

1 Wood J.G.M., « L’ingénierie forensique – l’approche anglaise », Colloque Le Pont, Univ. Toulouse, 22-23 oct. 2008.

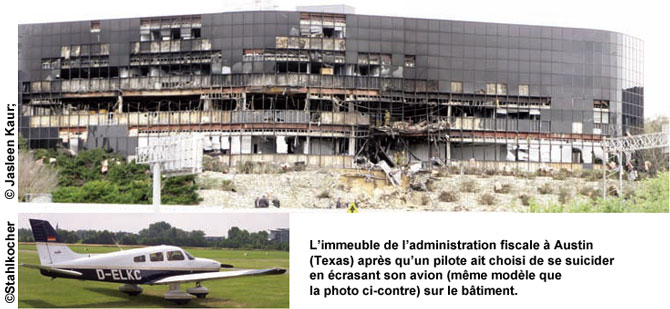

En effet, la construction des tours était régie par de fortes contraintes économiques. Il s’agissait d’une part de mener le chantier à son terme dans les meilleurs délais, d’où l’adoption de la peau périphérique préfabriquée qui permettait un rythme d’avancement très rapide, puisqu’il ne restait qu’à assembler les éléments sur place. Il fallait d’autre part pouvoir disposer de vastes espaces librement aménageables en bureaux modulables, d’où l’absence de tout élément porteur entre le noyau central et la peau. Quant au choc d’avion, nous savons que le 11 septembre a été une triste première dans l’histoire de l’humanité. Si des avions avaient déjà, par le passé, percuté des tours ou des gratte-ciels, il s’agissait d’accidents et d’avions de petites dimensions. Le cas le plus fameux était celui de l’Empire State Building, à New York, qu’un avion avait percuté le 28 juillet 1945. L’accident avait fait 13 victimes et était forcément présent à l’esprit des concepteurs. Après le 11 septembre, d’autres accidents se sont produits, dont le 19 avril 2002, contre la tour Pirelli à Milan, et celui récent (18 février 2010) d’un pilote choisissant pour se suicider de percuter un immeuble d’Austin au Texas. Aujourd’hui, aucun projet de gratte-ciel ne peut ignorer le scénario du 11 septembre. Si les concepteurs du WTC avaient intégré dans leur cahier des charges le choc d’un avion, ils l’avaient fait pour un avion de taille plus modeste et en sous-estimant les conséquences de l’incendie.

En résumé, nous sommes donc dans la situation d’un ouvrage dont (comme c’est en général le cas) la conception et le mode constructif reposent sur des choix techniques et économiques, et devant faire face à un événement sans précédent. Il s’est hélas comporté « normalement », comme une construction devant faire face à une action dont l’intensité dépasse largement celle pour laquelle il a été conçu. S’il ne s’est pas effondré dès le choc (il possédait des réserves de sécurité et pouvait donc tenir même si une partie de sa peau périphérique était détruite), l’incendie qui a suivi a dégradé progressivement la résistance des matériaux et provoqué le scénario fatal.

Jusqu’où peut-on se prémunir des effondrements catastrophiques ?

Pour les raisons que nous venons d’évoquer (choix d’un niveau de sécurité cible, occurrence d’événements exceptionnels, subsistance d’erreurs humaines), nous aurons toujours à faire face à un nombre résiduel d’événements catastrophiques.

Cependant, les règles concernant la sécurité des ouvrages ne cessent d’évoluer, sous la pression d’exigences croissantes des sociétés, et grâce à l’accumulation des connaissances. Les améliorations portent sur les matériaux et leur mise en œuvre, le calcul (avec le développement de moyens permettant de traiter des géométries complexes sous des chargements très variés), les principes de conception. Un nœud gordien demeure : celui des questions relatives à l’organisation collective (transmission d’informations entre acteurs, problèmes d’interfaces et de coordination...) dont les faiblesses peuvent conduire à des défaillances spectaculaires. Mais là aussi, les progrès sont possibles, sous réserve que l’on ne se limite pas à la dimension technique de la sécurité, mais que l’on aborde l’ensemble du projet de construction dans son ensemble.

Nous avons vu que les défaillances sont aussi source d’enseignement et d’amélioration. Ainsi, par exemple :

- plusieurs effondrements catastrophiques de ponts métalliques en cours de construction dans les années 1970 ont permis de mieux comprendre et prendre en compte les instabilités géométriques de types « voilement » dans les cadres minces ;

- l’effondrement brutal d’un plafond soutenu par des barres métalliques à la piscine d’Uster en Suisse, en 1985, a permis de mieux comprendre les problèmes posés par la corrosion sous contraintes ;

- la rupture brutale du pont gallois de Ynys-y-Gwas en 1985, au passage d’un véhicule, a mis un coup d’arrêt à l’emploi du béton précontraint au Royaume-Uni, jusqu’à ce que les ingénieurs puissent garantir que les méthodes constructives et la protection des câbles étaient désormais sans reproche ;

- les défaillances spectaculaires et répétées dans des tunnels urbains en cours de creusement ces quinze dernières années ont conduit l’ensemble de la profession à se mobiliser pour mettre en place des procédures d’accompagnement de ces projets permettant une meilleure maîtrise des risques.

L’effondrement du WTC a, lui aussi, conduit les ingénieurs à approfondir plusieurs questions-clés pour améliorer leurs approches de la sécurité dans les gratte-ciels. Par exemple, un point important est celui de la « robustesse ». On qualifie de « robuste » un système qui, après survenue d’une défaillance locale, même sévère, peut continuer à fonctionner de manière plus ou moins dégradée. Une construction « robuste » peut ainsi survivre à la destruction de certains de ses éléments porteurs, au moins de manière temporaire, permettant ainsi l’évacuation de ses occupants. L’exigence de robustesse a été introduite récemment dans les codes réglementaires, mais les ingénieurs ne disposaient pas d’outils et de méthodes pour quantifier la robustesse d’un ouvrage, ou comparer plusieurs solutions (cette question est devenue cruciale après l’attentat à l’explosif contre le Murrah Federal Building, qui a fait 168 victimes à Oklahoma City en avril 1995). Suite au 11 septembre, de nombreux programmes de recherche ont été lancés pour travailler sur la robustesse et améliorer la conception. Désormais, ce concept ne peut être absent lors de la conception initiale des gratte-ciels, dont il conditionnera le principe constructif, au même titre que d’autres exigences.

Cela ne garantira pas une sécurité parfaite, dont personne n’a d’ailleurs l’illusion. Certains événements aujourd’hui imprévisibles se produiront peut-être demain. Pour l’ingénieur, la tâche essentielle sera d’y faire face, et de s’en servir pour répondre mieux encore aux exigences de la société.

Publié dans le n° 296 Hors-série 11 septembre de la revue

Partager cet article

Conspirationnisme

Conspirationnisme et théories du complot sont des concepts aux frontières parfois floues. La sociologue Eva Soteras propose quatre « piliers » qui peuvent permettre de caractériser une théorie du complot : 1. l’absence de hasard ou de coïncidences ; 2. tous les événements sont le fruit d’actions cachées (« à qui profite le crime ? ») ; 3. tout n’est qu’illusion (« on nous ment ») 4. et tous les événements qui font l’histoire sont liés entre eux.

Théories du complot, conspirationnisme : de quoi parle-t-on ?

Le 29 juillet 2021

Complotisme et manipulation : entretien avec les auteurs

Le 11 octobre 2025

L’origine de la pandémie de Covid-19 : science et complotisme

Le 9 juillet 2025

Quand la fiction inspire les théories du complot

Le 8 janvier 2022

La vérité est ailleurs : le complotisme comme fiction

Le 4 janvier 2022